نظام التعرف على أصوات الحيوانات بإستخدام تقنيات الذكاء الإصطناعي

| التصنيف | مقالات وتدوينات |

| وقت النشر |

2020/08/27

|

| الردود |

0

|

1- مقدمة :

استخدام الأنظمة الإلكترونية للتعرف على أصوات الحيوانات تعد أداة ثمينة ومهمة بالنسبة للأبحاث البيولوجية وتطبيقات المراقبة البيئية لا سِيّما في البيئات الوعرة، لذلك استخدام أصوات الحيوانات للتعرف تلقائيًا على نوعـــها يعد طريقة مناسبة للرصد البيئي ومراقبة البيئة وتقييم التنوع البيولوجي ... إلخ. [1].

يتم استخدام شبكات أجهزة الاستشعار الصوتية اللاسلكية (WASN) مع خوارزميات التعلم الآلي للمراقبة طويلة المدى في المناطق الصعبة وذات الحجم الكبير، بدلًا من المراقبة التقليدية التي عادةً ما تتضمن زيارة علماء الأحياء والجيولوجيّين للمواقع جسديًّا لجمع البيانات البيئية، وهي عملية تستغرق وقتًا طويلًا وتكلفة مادية.

على مدى السنوات القليلة الماضية تم اقتراح مجموعة متنوّعة من تطبيقات المراقبة القائمة على الميزات الصوتية، ولكن القليل منها ركـَّـز على مراقبة البيئة من خلال تصنيف الأنواع المختلفة من الحيوانات بالاعتماد على ميزاتها الصوتية.

في هذا المقال نركّز بشكل أساسي على كيفية تحديد الأنواع المختلفة من الحيوانات آليًّا بناءً على صوتها المحدد في البيئة الخارجية، ويتناول هذا المقال الخوارزميّات والتقنيات المستخدمة لتصنيف الأصوات بشكل عام وأصوات الحيوانات بشكلً خاص آليًّا.

تعتمد جميع التقنيات والخوارزميّات المستخدمة لتصنيف الأصوات على الخطوات التالية [2] :

(1) المعالجة المسبقة للموجات الصوتية المسجلة (pre-processing).

(2) استخراج الميزات والسمات من الإشارة الصوتية feature extraction)).

(3) التصنيف بناءً على الميزات والسمات المستخرجة ((classification.

يوضح الشكل 1 النظام العام والخطوات المعتمدة للتعرف على الأصوات المسجلة للحيوانات [3] [4].

1-1 الأهداف:

كل حيوان في النظام البيئي له دور حيوي ونشط على هذا الكوكب، وانقراض أحد أنواع الحيوانات يمكن أن يكون له آثار متتالية كبيرة على التوازن البيئي، ويسبب خطرًا على التنوع البيولوجي العالمي.

يمكن أن تساعد مراقبة الحيوانات -وخاصة تلك التي أصبحت مهددة بالانقراض- الباحثين في علم الأحياء في جهود حفظها، وتحسين فهمهم لتفاعلاتها وسلوكها وبالتالي تأثيرها على النظام البيئي [4] [6].

أصبح تطوير تقنيات المراقبة أكثر أهمية؛ للحصول على رؤية واضحة حول الحيوانات، وتعد المراقبة الصوتية باستخدام شبكات الاستشعار الصوتية اللاسلكيّة هي واحدة من أفضل الآليّات التي أعطت نتائج جيدة في الكشف عن تهديد سوسة النخيل الحمراء في وقت مبكر، وهو واحد من أخطر التهديدات التي تسببت في خسائر كبيرة على زراعة النخيل في المملكة العربية السعودية [7].

2- المعالجة المسبقة للإشارة الصوتية:

بالنسبة لتصنيف أصوات الحيوانات فإن المعالجة المسبقة للإشارة الصوتية هي العمليّة الأولى بعد جمع البيانات الصوتية، وتتضمّن المعالجة المسبقة للإشارة الصوتية الخطوات التالية [4] [8] :

(1) معالجة الإشارة الصوتية.

(2) تقليل الضوضاء والضجيج في الإشارة الصوتية .

(3) تقسيم المقاطع .

2-1 معالجة الإشارة الصوتية :

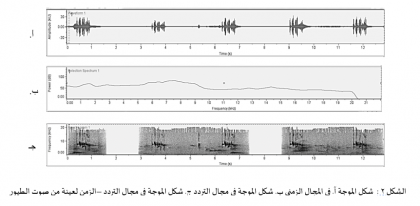

معالجة الإشارة الصوتية في نظام تصنيف أصوات الحيوانات (Animal sound classification) هو تحويل الإشارات الصوتية من شكل الموجة في المجال الزمني (waveform) إلى الشكل الطيفي في مجال التردد-الزمني (spectrogram) أو إلى شكل الطيف في مجال التردد (spectrum). يوضح الشكل 2 عينة لصوت طائر في شكل الموجة والطيف والتمثيل الطيفي باستخدام برنامج (Raven).

يوجد عدد من التقنيات المستخدمة في معالجة الإشارات الصوتية الحيوانية بما في ذلك على سبيل المثال لا الحصر: (FFT) التي تحول الإشارة الصوتية من شكل الموجة (waveform) في المجال الزمني إلى شكل الطيف مجال التردد (spectrum) [9] [10]، (STFT) و(WT) التي تحول الإشارة الصوتية من شكل الموجة (waveform) في المجال الزمني إلى شكل الطيفي في مجال التردد- الزمني (spectrogram) [11] [12].

تعد السمات أو القيم التردّدية (frequency features) من أهم السمات التي تُستخدم للتمييز بين الأصوات المختلفة للحيوانات، وللحصول على تلك السمات التردّديّة الطيفيّة المرغوبة لتمثيل الإشارة الصوتية يتم تحويل الصوت الذي تم الحصول عليه من المجال الزمني (waveform) إلى مجال التردد (spectrum) باستخدام (FFT) [3].

يمكن التعبير عن(FFT) في المعادلة رقم 1؛ حيث أن (f(k)) هي الإشارة الصوتية في المجال الترددي (الطيف) و(f(t)) في الإشارة الصوتية المجال الزمني [11].

2-2 تقليل الضوضاء والضجيج في الإشارة الصوتية:

تخفيض الضوضاء في الإشارة الصوتية لاستخراج إشارة نقية يعد خطوة اختيارية في عملية تصنيف أصوات الحيوانات [2] [3]، توجد عدد من التقنيات المستخدمة لتخفيض الضوضاء من الصوت منها :

(1) مرشح إزالة الضوضاء (de-noise filter) : وهو أسلوب معروف لإزالة الضوضاء من الصوت المسجل [12] [13].

(2) منهجية بوابة الضوضاء الطيفية (spectral noise gating methodology): التي تستخدم لتقدير وإزالة المكونات الصاخبة والمزعجة في الطيف المحدد للإشارة [14].

2-3 تقسيـــــــم المقاطع:

الموجات الصوتية المستمرة المنبعثة من أي حيوان تتكون من مقاطع (syllables) متكررة طوال فترة الموجة الصوتية المحددة، المقطع هو وحدة أساسية للتصنيف -على وجه الخصوص يتم الحصول على مجموعة المميزات والسمات (features) من المقاطع- وبالتالي فإن دقَّة تجزئة المقطع تؤثر بشكل مباشر على دقة التصنيف [3] [15]، وتوجد عدد من التقنيات المستخدمة لتقسيم المقاطع في الموجات الصوتية منها :

(1) خوارزمية تكرار المجال الزمني (iterative time-domain algorithm): التي استخدمت السعة (amplitude) في المجال الزمني كميزة لتجزئة الإشارة الصوتية [16].

(2) خوارزمية تجزئة نقطة النهاية التكيفية (adaptive-end-point segmentation (algorithm: التي تقوم باستخراج المقاطع من خلال قياس مواضع نقطتي النهاية لأشكال الموجة؛ بحيث أن ميزة ذورة السعة (peak amplitude) ستكون في منتصف كل مقطع [17].

(3) خوارزمية التجزئة التدريجية (incremental segmentation approach): التي تحسب بشكل متزايد الطاقة ومعدل التقاطع صفري (Zero Crossing Rate) في الإشارات الصوتية لاستخراج المقاطع [15].

3-اخراج المميزات والسمات من الإشارة الصوتية:

عملية اختيار السمات والمميزات الصوتية المناسبة التي تظهر الاختلافات بين الأصوات المختلفة هو المفتاح لتحقيق تصنيف فعال ودقيق، ويمكن استخدام مجموعة من الميزات لوصف الإشارة الصوتية؛ لتصنيف أصوات الحيوانات، ويمكن تصنيف الميزات الصوتية بناءً على مجال حسابها إلى ست فئات: مميزات الوقت (time features) والتي تتأثر بشدة بالضوضاء البيئية كصوت الرياح؛ لذلك يتم دمجها عادة مع مميزات من فئات أخرى، ومميزات الطاقة (energy features)، ومميزات التردد (frequency (spectral) features) التي تتميّز بقوتها ضد الأصوات البيئية وبتكلفتها العالية حسابيًّا، ومميزات ((cepstral، وميزات البيولوجية (Biologically/Perceptually features)، ومميزات التردد –الوقت (time-frequency features) [3] [ 4] [18]. في الجدول 1 يتم توضيح مجموعة من المميزات المستخرجة من الإشارات الصوتية والفئات التي تندرج تحتها.

الفئات | المميزات (Features) | المراجع | ||

|---|---|---|---|---|

مميزات التردد (frequency (spectral) features) | Spectral centroid Signal bandwidth Spectral roll-off Spectral flatness Fundamental frequency Spectral flux Spectral spread Spectral skewness Spectral kurtosis Spread Variation Crest Timbre Pitch | ] 17 [،] 12 [،] 13 [،] 16 [،] 19 [،] 20 [،] 21 [،] 22 [ | ||

مميزات الوقت (time features) | Threshold- Crossing Rate ZCR Syllable duration Root Mean Square (RMS) Log-attack time Loudness | ] 13 [،] 12 [، ] 11 [،]16 [،] 17 [،] 21 [،] 22 [ | ||

مميزات الطاقة (energy features) | Average energy Shannon entropy Rényi entropy Signal power Temporal centriod | ] 11 [،] 12 [، ]17 [،] 19 [،]20 [، ] 22 [ |

مميزات ((cepstral | Mel Frequency Cepstral Coefficients (MFCC) | ] 17 [،] 22 [، ] 23 [،] 24 [ | ||

| Linear Prediction Coefficients (LPC) Perceptual spectral centroid Odd-to-Even ratio Tristimulus Slope | ] 17 [،] 22 [ | ||

مميزات تردد –الوقت | Spectral peak tracks Wavelet coefficients Oscillation rate Dominant frequency The frequency difference between the lowest and dominant frequencies. The frequency difference between the highest and dominant frequencies. Time from the start of the sound to the peak volume. Time from the peak volume to the end of the sound. | ] 23 [،] 11 [، ] 24 [ |

4- التصنيف بناءً على المميزات والسمات المستخرجة من الإشارة الصوتية:

عمليّة التصنيف تعد الخطوة الأخيرة في نظام التصنيف الصوتي، وقد تم استخدام بعض تقنيات التعرف على الأنماط لإنشاء المصنف (classifier)، والذي يستخدم السمات والمميزات المستخرجة من الإشارة الصوتية لتحديد كل صوت إلى أي فئة (من أنواع الحيوانات ) ينتمي إليه، أمثلة على (classifiers) المصنفات :

(1) المصنف kNN k-Nearest Neighbors)): الذي يعتمد على قاعدة الجوار الأقرب، ويعتبر من أكثر المصنفات استخدامًا لبساطته وسهولة تطبيقه برمجيًّا ] 17 [,]13. [

(2) المصنف (Support Vector Machine) SVM ]17 [.

(3) مصنف الشبكات العصبية NN (Neural Network) ] 12 [.

(4) المصنف CNN (Convolutional Neural Network) ]25 [.

(5) المصنف One-way multivariate ANOVA ]21 [.

(6) المصنف التمييزي التحليلي الخطي (LDA) ] 17. [

بدور عبدالله الملحم

المراجع:

1- A. D. Mane, R. A. Rashmi, and S. L. Tade, “Identification & Detection System for Animals from their Vocalization,” no. 3, pp. 1–6, 2013.

2- P. Xie, Jie, Towsey, Michael, Yasumiba, Kiyomi, Zhang, Jinglan, Roe, “Detection of anuran calling activity in long field recordings for bio-acoustic monitoring,” IEEE Int. Conf., 2015.

3- J. Xie, “Acoustic classification of Australian frogs for ecosystem surveys,” 2017.

4- D. Mitrovic, M. Zeppelzauer, and C. Breiteneder, “Discrimination and Retrieval of Animal Sounds,” 2006 12th Int. Multi-Media Model. Conf., pp. 339–343, 2005.

5- A. Bertrand, “Applications and trends in wireless acoustic sensor networks: A signal processing perspective,” 2011 18th IEEE Symp. Commun. Veh. Technol. Benelux, SCVT 2011, 2011.

6- J. Xie, M. Towsey, J. Zhang, and P. Roe, “Frog call classification: a survey,” Artif. Intell. Rev., pp. 1–17, 2016.

7- A. D. Mane, R. A. Rashmi, and S. L. Tade, “Identification & Detection System for Animals from their Vocalization,” no. 3, pp. 1–6, 2013.

8- J. Xie, M. Towsey, J. Zhang, and P. Roe, “Frog call classification: a survey,” Artif. Intell. Rev., pp. 1–17, 2016.

9- B. Chen, “Audio Recognition with Distributed Wireless Sensor Networks,” pp. 1–48, 2010.

10- P. Xie, Jie, Towsey, Michael, Yasumiba, Kiyomi, Zhang, Jinglan, Roe, “Detection of anuran calling activity in long field recordings for bio-acoustic monitoring,” IEEE Int. Conf., 2015.

11- Z. Chen and R. C. Maher, “Semi-automatic classification of bird vocalizations using spectral peak tracks,” J. Acoust. Soc. Am., vol. 120, no. 5, pp. 2974–2984, 2006.

12- C. J. Huang et al., “Intelligent feature extraction and classification of anuran vocalizations,” Appl. Soft Comput. J., vol. 19, pp. 1–7, 2014.

13- C. J. Huang, Y. J. Yang, D. X. Yang, Y. J. Chen, and H. Y. Wei, “Realization of an intelligent frog call identification agent,” Lect. Notes Comput. Sci. (including Subser. Lect. Notes Artif. Intell. Lect. Notes Bioinformatics), vol. 4953 LNAI, pp. 93–102, 2008.

14- C. Bedoya, J. M. Daza, and J. D. Lopez, “Automatic Recognition of Anuran Species Based on Syllable Identification,” Ecol. Inform., vol. 24, no. January 2016, 2014.

15- J. G. Colonna, M. Cristo, M. Salvatierra, and E. F. Nakamura, “An incremental technique for real-time bioacoustic signal segmentation,” Expert Syst. Appl., vol. 42, no. 21, pp. 7367–7374, 2015.

16- C. J. Huang, Y. J. Yang, D. X. Yang, and Y. J. Chen, “Frog classification using machine learning techniques,” Expert Syst. Appl., vol. 36, no. 2 PART 2, pp. 3737–3743, 2009.

17- J. Xie, M. Towsey, J. Zhang, and P. Roe, “Acoustic classification of Australian frogs based on enhanced features and machine learning algorithms,” Appl. Acoust., vol. 113, pp. 193–201, 2016.

18- S. Chu, S. Narayanan, and C.-C. J. Kuo, “Environmental Sound Recognition With Time – Frequency Audio Features,” IEEE Trans. Audio. Speech. Lang. Processing, vol. 17, no. 6, pp. 1142–1158, 2009.

19- N. C. Han, S. V. Muniandy, and J. Dayou, “Acoustic classification of Australian anurans based on hybrid spectral-entropy approach,” Appl. Acoust., vol. 72, no. 9, pp. 639–645, 2011.

20- J. Xie, Z. Jinglan, and P. Roe, “Acoustic features for multi-level classification of Australian frogs : Family , Genus and Species,” IEEE, pp. 1–5, 2015.

21- A. Camacho, A. Garcia Rodriguez, and F. Bolanos, “Automatic detection of vocalizations of the frog Diasporus hylaeformis in audio recordings,” J. Acoust. Soc. Am., vol. 130, no. 4, p. 2500, 2011.

22- S. Gunasekaran and K. Revathy, “Automatic Recognition and Retrieval of Wild Animal Vocalizations,” IJCTE Int. J. Comput. Theory Eng., vol. 3, no. 1, p. 136-140, 2011.

23- J. G. Colonna, A. D. Ribas, E. M. Santos, and E. F. Nakamura, “Feature Subset Selection for Automatically Classifying Anuran Calls Using Sensor Networks,” pp. 10–15, 2012.

24- J. Xie, M. Towsey, A. Truskinger, P. Eichinski, J. Zhang, and P. Roe, “Acoustic classification of Australian anurans using syllable features,” Information, Commun. Signal Process. (ICICS), 10th Int. Conf. on. IEEE, 2015.

25- J. Colonna, T. Peet, C. A. Ferreira, A. M. Jorge, E. F. Gomes, and J. Gama, “Automatic Classification of Anuran Sounds Using Convolutional Neural Networks,” Proc. Ninth Int. C* Conf. Comput. Sci. Softw. Eng. - C3S2E ’16, pp. 73–78, 2016.

التعليقات (0)

لم يتم إضافة ردود حتى الآن...